Chain of Thought: differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| (Una versione intermedia di uno stesso utente non è mostrata) | |||

| Riga 4: | Riga 4: | ||

}} | }} | ||

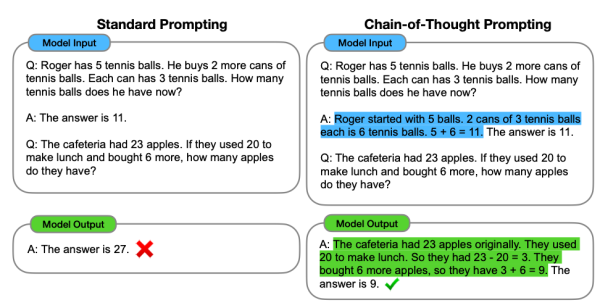

Il concetto di '''Chain of Thought''' rappresenta il processo cognitivo simulato da un LLM, nel quale si sviluppa una sequenza di affermazioni, domande, o deduzioni logiche che portano dalla domanda iniziale alla conclusione finale. | Il concetto di '''Chain of Thought''', formalizzato nella pubblicazione [[Chain of Thought Prompting Elicits Reasoning in Large Language Models]], rappresenta il processo cognitivo simulato da un LLM, nel quale si sviluppa una sequenza di affermazioni, domande, o deduzioni logiche che portano dalla domanda iniziale alla conclusione finale. | ||

Questo processo mira a emulare il modo in cui gli esseri umani ragionano su vari argomenti, collegando tra loro concetti differenti per arrivare a una '''risposta coerente e giustificata'''. | Questo processo mira a emulare il modo in cui gli esseri umani ragionano su vari argomenti, collegando tra loro concetti differenti per arrivare a una '''risposta coerente e giustificata'''. | ||

In pratica, anziché tentare di arrivare a una risposta in un unico passaggio, il modello genera una serie di '''passaggi intermedi'''. Questo approccio permette al modello di affrontare ciascun aspetto del problema in modo più approfondito, facilitando la comprensione e la risoluzione di domande complesse. | In pratica, anziché tentare di arrivare a una risposta in un unico passaggio, il modello genera una serie di '''passaggi intermedi'''. Questo approccio permette al modello di affrontare ciascun aspetto del problema in modo più approfondito, facilitando la comprensione e la risoluzione di domande complesse. | ||

La "Chain of Thought" aiuta a rendere il processo decisionale del modello più trasparente e le sue risposte più accurate e affidabili, migliorando significativamente le performance in compiti che richiedono un ragionamento complesso. | La "Chain of Thought" aiuta a rendere il processo decisionale del modello più trasparente e le sue risposte più accurate e affidabili, '''migliorando significativamente le performance in compiti che richiedono un ragionamento complesso.''' | ||

[[File:Chain Of Thought Prompting.png|centro|miniatura|600x600px|Chain Of Thought Prompting]] | |||

{{#seo: | {{#seo: | ||

Versione attuale delle 11:30, 6 set 2024

| Chain of Thought | |

|---|---|

| Nome Inglese | Chain of Thought |

| Sigla | CoT |

Il concetto di Chain of Thought, formalizzato nella pubblicazione Chain of Thought Prompting Elicits Reasoning in Large Language Models, rappresenta il processo cognitivo simulato da un LLM, nel quale si sviluppa una sequenza di affermazioni, domande, o deduzioni logiche che portano dalla domanda iniziale alla conclusione finale.

Questo processo mira a emulare il modo in cui gli esseri umani ragionano su vari argomenti, collegando tra loro concetti differenti per arrivare a una risposta coerente e giustificata.

In pratica, anziché tentare di arrivare a una risposta in un unico passaggio, il modello genera una serie di passaggi intermedi. Questo approccio permette al modello di affrontare ciascun aspetto del problema in modo più approfondito, facilitando la comprensione e la risoluzione di domande complesse.

La "Chain of Thought" aiuta a rendere il processo decisionale del modello più trasparente e le sue risposte più accurate e affidabili, migliorando significativamente le performance in compiti che richiedono un ragionamento complesso.