Apprendimento per rinforzo da feedback umano

| Apprendimento per rinforzo da feedback umano | |

|---|---|

| Nome Inglese | Reinforcement Learning From Human Feedback |

| Sigla | RLHF |

Pronunciato Ar-El-Eic-Ef, RLHF è una tecnica avanzata per allineare gli output di un Modello di Linguaggio (Language Model, LM) alle intenzioni e alle preferenze degli utenti. Questo metodo è particolarmente utile per affinare i modelli di linguaggio su compiti specifici, come il riassunto di testi, garantendo che gli output siano non solo accurati ma anche allineati con le preferenze umane.

Esempio Pratico

Consideriamo il processo di fine-tuning di un modello di linguaggio per il compito di summarization. Prepariamo delle coppie di esempi nel formato:

- {testo originale, riassunto proposto}

Supponendo che per lo stesso testo si generino diversi riassunti validi, si introduce la necessità di determinare quale riassunto sia preferito. In questo contesto, RLHF opera attraverso un formato specifico:

- RLHF: {testo di input, riassunto 1, riassunto 2, preferenza umana}

Meccanismo di Funzionamento

Il processo di RLHF si articola in diverse fasi chiave:

- Preparazione del Dataset di Preferenze: Si inizia con la creazione di un dataset basato sulle preferenze, registrando le scelte preferenziali tra diverse opzioni di output fornite dal modello.

- Allenamento Supervisionato del Modello di Reward: Si procede con l'allenamento di un modello di reward, anch'esso un modello di linguaggio, utilizzando il dataset di preferenze. Questo modello è addestrato per predire la preferenza umana tra coppie di output generati in risposta allo stesso prompt.

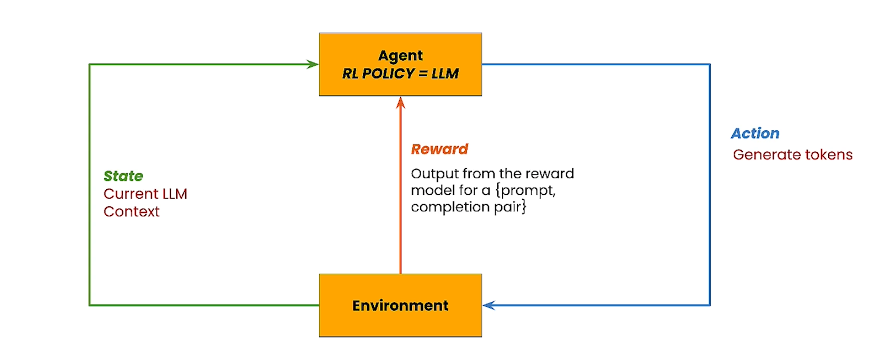

- Reinforcement Learning (RL) in Loop: Si utilizza il modello di reward in un ciclo di RL per il fine-tuning del modello di linguaggio principale. L'obiettivo è massimizzare il reward (premio) indicato dal modello di reward, ottimizzando così gli output del modello di linguaggio per riflettere le preferenze umane.

Dettagli Tecnici

- Partendo da un modello base, ad esempio Llama, si generano molteplici output per lo stesso prompt.

- Un annotatore umano valuta gli output generati, indicando la sua preferenza. Questo passaggio è cruciale per garantire che il modello sia allineato con i valori e le preferenze desiderati.

- Si allena un Modello di Reward utilizzando i dati raccolti, configurandolo per minimizzare la funzione di perdita e predire accuratamente le preferenze umane.

- Il fine-tuning del modello di linguaggio avviene attraverso un loop di RL, impiegando la tecnica Proximal Policy Optimization (PPO) (oppure GRPO come in per Deepseek) ottimizzare le scelte del modello in base al feedback ricevuto.

RLHF è particolarmente efficace in scenari dove non esiste una risposta univocamente corretta, ma è desiderabile orientare le risposte del modello di linguaggio secondo determinate preferenze o valori.

Links

Tutorial

- Tutorial su Deeplearning.ai

- RLHF: Reinforcement Learning from Human Feedback

- https://openai.com/index/instruction-following/

- https://huggingface.co/docs/trl/main/en/ppo_trainer

Paper

- Deep Reinforcement Learning from Human Preferences

- Training language models to follow instructions with human feedback