RecurrentGPT

Rilasciato da : Wangchunshu Zhou, Yuchen Eleanor Jiang, Peng Cui, Tiannan Wang, Zhenxin Xiao, Yifan Hou, Ryan Cotterell, Mrinmaya Sachan, ETH Zürich

Data di pubblicazione : 23 maggio 2023

Accesso : Open source

Descrizione

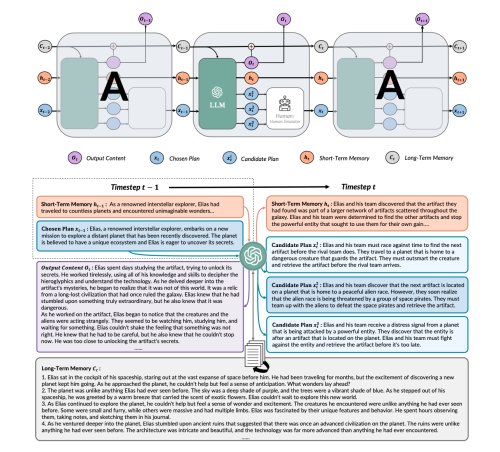

RecurrentGPT è un modello avanzato multilingua di intelligenza artificiale che estende le capacità dei grandi modelli di linguaggio (come ChatGPT) con un meccanismo di ricorrenza ispirato agli RNN (Reti Neurali Ricorrenti) e agli LSTM (Long Short-Term Memory). Attraverso l'uso di linguaggio naturale come blocchi costruttivi, RecurrentGPT simula la memoria a lungo e breve termine, consentendo la generazione di testi di lunghezza arbitraria e superando le limitazioni di contesto fisse dei modelli Transformer tradizionali. Questo approccio rende RecurrentGPT altamente interpretabile e interattivo, permettendo agli utenti di osservare, modificare e influenzare direttamente il processo di generazione del testo.

Architettura

Baseline

- Rolling-ChatGPT: questa baseline si basa sull'idea di stimolare iterativamente ChatGPT a proseguire la scrittura di un testo una volta raggiunto il suo limite di contesto. In pratica, si comincia fornendo a ChatGPT un genere letterario e alcuni dettagli o impostazioni di sfondo come punto di partenza per scrivere un romanzo. Una volta che ChatGPT ha generato una quantità di testo che si avvicina o raggiunge il limite massimo del contesto che può gestire, l'utente o un meccanismo automatizzato fornisce nuovamente al modello una porzione del testo più recente, sollecitandolo a continuare da dove si era interrotto. Solo una parte del testo generato precedentemente (la parte più recente o rilevante) viene utilizzata nuovamente come input per generare la porzione successiva del testo. Ciò permette teoricamente di produrre testi di lunghezza arbitraria , sfruttando la capacità di ChatGPT di generare testi coerenti e contestualmente pertinenti basandosi sull'input ricevuto, ma richiede una gestione attenta del contesto per mantenere la coerenza e la continuità dell'intero testo. Sebbene questa tecnica possa essere efficace, potrebbe comunque presentare sfide relative alla coerenza del testo su lunghe distanze, poiché il modello ha sempre una vista limitata dell'intero contenuto generato fino a quel momento.

- RE3: questa baseline si riferisce a un approccio strutturato per la generazione di storie lunghe attraverso l'uso di modelli di linguaggio di grandi dimensioni (LLM), come ChatGPT. Questo metodo si basa su una strategia gerarchica che procede in più fasi per costruire narrazioni complesse e dettagliate: 1. Generazione del Contorno: Nella prima fase, RE3 sollecita un LLM a creare un abbozzo o contorno generale della storia. Questo contorno funge da mappa per l'intera narrazione, delineando i principali eventi, personaggi e punti di svolta. L'idea è quella di stabilire una struttura di base che guiderà la generazione successiva del testo, assicurando che la storia abbia una trama coerente e logicamente organizzata. 2. Generazione della Storia: Una volta definito il contorno, il modello procede con la generazione del testo della storia seguendo la struttura predefinita. In questa fase, il LLM espande ciascuna sezione del contorno in narrazioni dettagliate, popolando la storia con dialoghi, descrizioni e azioni che arricchiscono il racconto. 3. Pipeline di Ri-classificazione e Ri-scrittura: Dopo la generazione iniziale della storia, RE3 impiega ulteriori passaggi di elaborazione, come la ri-classificazione e la ri-scrittura, per rifinire il testo. Questi processi possono includere l'aggiustamento di tono e stile, la correzione di incoerenze narrative, il miglioramento della coesione tra le parti della storia e l'assicurazione che il testo finale sia di alta qualità. Queste fasi di post-elaborazione sono cruciali per assicurare che la storia sia non solo coerente con il contorno iniziale, ma anche avvincente e ben scritta .

- DOC: questa baseline riguarda un approccio avanzato nella generazione automatica di storie lunghe, che rappresenta un'evoluzione del metodo RE3. DOC si distingue per la sua capacità di offrire un maggiore controllo sull'outline (contorno) della storia, permettendo di guidare più dettagliatamente la narrazione e assicurando che la trama segua fedelmente la struttura predefinita. Questa maggiore precisione nell'outline mira a migliorare la coerenza e la qualità complessiva delle storie generate. La "ri-implementazione" di DOC con ChatGPT consiste nell'adattare il metodo originale, precedentemente basato su un modello diverso (come l'OPT-175B), per utilizzare le capacità avanzate di ChatGPT. Questo cambiamento è significativo poiché ChatGPT è noto per la sua eccellente comprensione del linguaggio naturale e le abilità di generazione di testo. Tuttavia, una sfida in questa transizione è rappresentata dall' impossibilità di accedere direttamente ai "pesi" (i parametri interni) di ChatGPT, il che rende inutilizzabile il "controller dettagliato" presente in DOC. Il controller dettagliato era un componente di DOC che permetteva di influenzare finemente il processo di generazione del testo, basandosi sui parametri interni del modello. Per superare questa limitazione, la ri-implementazione si concentra sull' uso delle capacità intrinseche di ChatGPT, adattando il processo per funzionare senza la necessità di modificare direttamente i pesi del modello. Anche se questo potrebbe sembrare una restrizione, in realtà si scopre che l'uso di ChatGPT porta a una qualità del testo generato leggermente migliore sfruttando le avanzate capacità linguistiche di ChatGPT per produrre storie più fluide, interessanti e coerenti. Questo miglioramento è attribuibile alla superiorità di ChatGPT in termini di comprensione del contesto, coerenza narrativa e capacità di generazione del linguaggio, che compensano l'assenza del controller dettagliato.

Caratteristiche Principali

Applicazioni

Risultati e Metriche di valutazione

Le applicazioni condotte dimostrano che RecurrentGPT eccelle nella generazione di testi lunghi, mantenendo le metriche di valutazione (coerenza e coinvolgimento) anche oltre le capacità di ChatGPT non modificato. È stato testato con successo in vari generi narrativi, dimostrando la sua versatilità e robustezza.

Limitazioni

Sebbene RecurrentGPT possa generare testi arbitrariamente lunghi, è stato valutato solo in contesti in cui i testi generati sono al massimo di circa 5000 parole . Un'altra limitazione è la sua dipendenza da LLM avanzati (ChatGPT e GPT-4) e nella gestione di testi estremamente lunghi. Si pensa che questo problema possa essere alleviato quando verranno sviluppati LLM più piccoli e potenti.

Prospettiva futura

RecurrentGPT segna un passo importante verso la realizzazione di sistemi di scrittura assistita da computer di prossima generazione, offrendo una soluzione promettente per superare le limitazioni esistenti nella generazione di testi lunghi e aprire nuove frontiere nell'uso creativo dell'IA.

Link

Paper

RecurrentGPT: Interactive Generation of (Arbitrarily) Long Text (Maggio 2023): paper originale

Github

Demo

Video

RecurrentGPT: Generate Larger Text EASILY Compared to ChatGPT