Stable Diffusion: differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| Riga 3: | Riga 3: | ||

== Principale differenza dagli altri modelli di generazione di immagini == | == Principale differenza dagli altri modelli di generazione di immagini == | ||

Diversamente da [[VAE]] e [[GAN]], che generano le immagini in un solo passaggio, Stable Diffusion genera le immagini iterativamente. | Diversamente da [[VAE]] e [[Generative Adversarial Networks (GAN)]], che generano le immagini in un solo passaggio, Stable Diffusion genera le immagini iterativamente. | ||

== Architettura == | == Architettura == | ||

Versione delle 14:01, 3 mar 2024

Nella sua forma più semplice è un modello text-to-image, dato un prompt testuale, genera un'immagine corrispondente. E' stato finanziato da Stability AI, ed è stato rilasciato nel 2022.

Principale differenza dagli altri modelli di generazione di immagini

Diversamente da VAE e Generative Adversarial Networks (GAN), che generano le immagini in un solo passaggio, Stable Diffusion genera le immagini iterativamente.

Architettura

Utilizza un tipo di Modello Di Diffusione, anche chiamato LDM (Modello di Diffusione Latente, che consiste di tre parti.

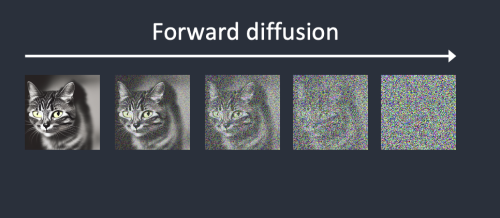

- Durante il processo di codifica, o Forward Diffusion, un VAE - Variational Autoencoder comprime l'immagine dallo spazio dei pixel a uno spazio latente con meno dimensioni, catturando il significato semantico dell'immagine, da cui il termine LDM (Modello di Diffusione Latente.

In maniera iterativa viene poi aggiunto del rumore gaussiano alle rappresentazioni delle immagini come vettori in questo spazio latente, in step, finchè non diventa rumore bianco. Un tipico numero di iterazioni è 1000.

- Una rete U-Net, che rimuove il rumore

Addestramento

Addestramento

Inizialmente introdotto nel paper Taming Transformers for High-Resolution Image Synthesis (23/06/2021).

Taming Transformers for High-Resolution Image Synthesis