Language Models are Few-Shot Learners: differenze tra le versioni

Nessun oggetto della modifica |

m (Alesaccoia ha spostato la pagina Language Models are Few-Shot Learners (2020) a Paper:Language Models are Few-Shot Learners (2020)) |

(Nessuna differenza)

| |

Versione delle 07:53, 23 feb 2024

Il paper, pubblicato il 22 luglio 2020 da OpenAI, discute delle capacità di apprendimento few-shot learning dei modelli di linguaggio, in particolare di GPT-3, modello autoregressivo da 175 miliardi di parametri.

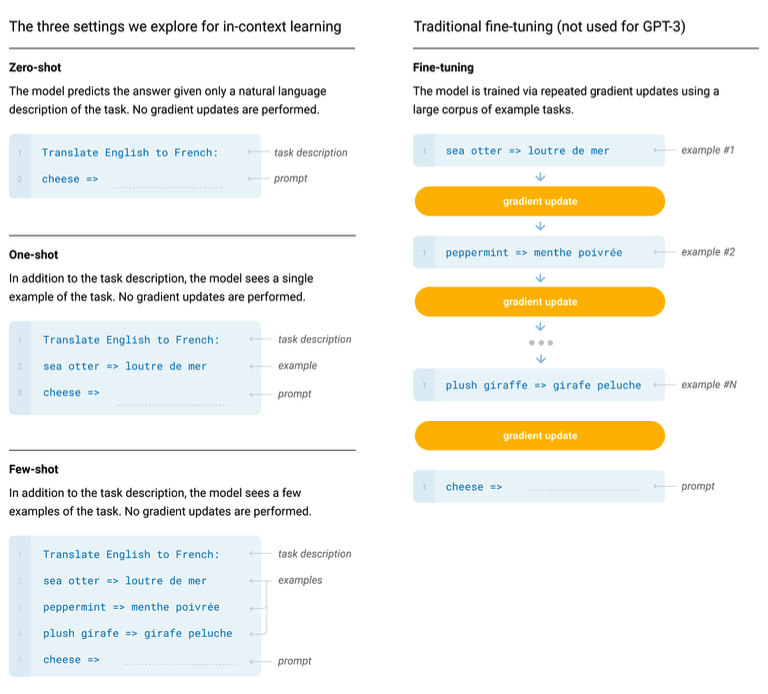

L'informazione più importante da questo punto di vista è il posizionamento del modello GPT-3 all'apice dell'evoluzione dei modelli di linguaggio per i vari downstream task. Esso supera il trend precedente che operava un fine-tuning su modelli generalisti, quindi togliendo la necessità di avere architetture specifiche per ogni task, che permise un avanzamento su tutti i benchmark ma che comunque necessitava di dataset annotati nell'ordine delle decine o centinaia di migliaia di osservazioni.

Viene osservato che esistono tantissimi possibili task, dalla correzione della grammatica, alla generazione di dataset sintetici, alla recensione di romanzi brevi. Per molti di essi è difficile se non impossibile ottenere dei dataset annotati. Viene anche evidenziato che all'aumentare della dimensione dei modelli, il fine tuning su task molto specifici ha delle proprietá statistiche non desiderabili, portando a una mancata generalizzazione. In più, gli umani spesso hanno bisogno solo di poche indicazioni per imparare la maggior parte dei task linguistici ("please tell me if this sentence describes something happy or something sad"), o al massimo di qualche esempio ("here are two examples of people acting brave; please give a third example of bravery").