LongAlign: differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| Riga 10: | Riga 10: | ||

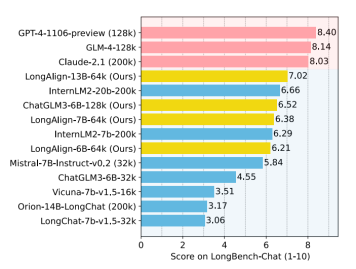

3. '''Valutazione su Compiti Complessi''': LongAlign testa i modelli su '''LongBench-Chat''', un benchmark che presenta domande di lunghezza reale da '''10k a 100k caratteri'''. Questo tipo di valutazione assicura che il modello non solo possa gestire testi lunghi, ma che possa anche comprendere e rispondere a domande complesse basate su quei testi. | 3. '''Valutazione su Compiti Complessi''': LongAlign testa i modelli su '''LongBench-Chat''', un benchmark che presenta domande di lunghezza reale da '''10k a 100k caratteri'''. Questo tipo di valutazione assicura che il modello non solo possa gestire testi lunghi, ma che possa anche comprendere e rispondere a domande complesse basate su quei testi. | ||

[[File:Screenshot_2024-03-20_152310.png|centro|miniatura|356x356px|Risultati dei test su LongBench-Chat, che contiene query del mondo reale di lunghezza da 10k a 100k.]] | |||

L'importanza di LongAlign risiede nella sua capacità di spingere i limiti di ciò che i LLM possono fare. Tradizionalmente, i LLM lottano con testi lunghi a causa delle limitazioni di memoria e attenzione, ma LongAlign offre un modo per superare tali limiti. Inoltre, il metodo garantisce che i modelli rimangano versatili, mantenendo alte prestazioni su una vasta gamma di compiti, sia che richiedano la gestione di poche righe di testo o l'analisi di interi documenti. | L'importanza di LongAlign risiede nella sua capacità di spingere i limiti di ciò che i LLM possono fare. Tradizionalmente, i LLM lottano con testi lunghi a causa delle limitazioni di memoria e attenzione, ma LongAlign offre un modo per superare tali limiti. Inoltre, il metodo garantisce che i modelli rimangano versatili, mantenendo alte prestazioni su una vasta gamma di compiti, sia che richiedano la gestione di poche righe di testo o l'analisi di interi documenti. | ||

Versione delle 14:32, 20 mar 2024

LongAlign è una tecnica avanzata progettata per aiutare i grandi modelli di intelligenza artificiale a comprendere e gestire testi molto lunghi in modo più efficace. Questo metodo introduce un modo nuovo per preparare i modelli a capire meglio le istruzioni complesse e a rispondere in maniera più accurata su argomenti estesi.

Funzionamento di LongAlign:

1. Costruzione di un Dataset Specifico: Prima di tutto, LongAlign crea un insieme di dati appositamente progettato per addestrare i LLM su contesti lunghi. Questo set di dati comprende esempi che coprono una vasta gamma di argomenti e formati, assicurando che il modello possa imparare a gestire una varietà di materiali lunghi.

2. Tecniche di Addestramento Efficienti: LongAlign utilizza strategie di addestramento innovative per accelerare il processo di apprendimento senza sacrificare la qualità. Due approcci chiave sono il "packing" e il "batching ordinato". Il packing consiste nel combinare insieme diversi pezzi di testo fino a raggiungere una lunghezza massima, ottimizzando l'uso delle risorse di calcolo. Il batching ordinato raggruppa i testi di lunghezza simile per minimizzare i tempi morti. Questi metodi aiutano il modello a imparare in modo più efficiente da grandi volumi di testo.

3. Valutazione su Compiti Complessi: LongAlign testa i modelli su LongBench-Chat, un benchmark che presenta domande di lunghezza reale da 10k a 100k caratteri. Questo tipo di valutazione assicura che il modello non solo possa gestire testi lunghi, ma che possa anche comprendere e rispondere a domande complesse basate su quei testi.

L'importanza di LongAlign risiede nella sua capacità di spingere i limiti di ciò che i LLM possono fare. Tradizionalmente, i LLM lottano con testi lunghi a causa delle limitazioni di memoria e attenzione, ma LongAlign offre un modo per superare tali limiti. Inoltre, il metodo garantisce che i modelli rimangano versatili, mantenendo alte prestazioni su una vasta gamma di compiti, sia che richiedano la gestione di poche righe di testo o l'analisi di interi documenti.

Link

Paper

LongAlign: A Recipe for Long Context Alignment of Large Language Models: paper originale