BABILong: differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| Riga 1: | Riga 1: | ||

BABILong è un benchmark progettato per valutare le capacità del modello nell'estrazione ed elaborazione di fatti distribuiti all'interno di testi estesi. | '''BABILong''' è un benchmark progettato per valutare le capacità del modello nell'estrazione ed elaborazione di fatti distribuiti all'interno di testi estesi. | ||

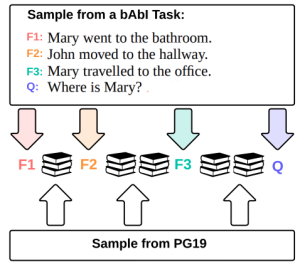

Risolvere compiti con una dimensione di contesto lunga richiede al modello di distinguere informazioni importanti da grandi quantità di dettagli irrilevanti. Per simulare questo comportamento, "nascondiamo" le frasi del compito originale tra le frasi di testo irrilevante che proviene da un'altra distribuzione strettamente correlata (vedi Figura 1). | |||

[[File:Screenshot 2024-03-20 alle 14.17.32.png|centro|miniatura|'''Figura1:''' Esempio di generazione per il dataset BABILong. Le affermazioni rilevanti per la domanda da un campione di bAbILong sono nascoste all'interno di testi più ampi e irrilevanti provenienti da PG19.]] | |||

Questo approccio è basato sui primi test "'''ago nel pagliaio'''". Si tratta di un test che mira a testare la capacità di un sistema AI di '''identificare''', '''estrarre''', o '''riconoscere''' un'informazione molto specifica o un elemento (l'"ago") da un vasto insieme di dati o informazioni non pertinenti (il "pagliaio"). Questo concetto può essere applicato in vari ambiti, come il riconoscimento di pattern, la ricerca di informazioni, il processamento del linguaggio naturale, e altri campi dell'AI dove il sistema deve dimostrare di poter effettivamente "trovare l'ago nel pagliaio". | |||

== Link == | == Link == | ||

Versione delle 13:47, 20 mar 2024

BABILong è un benchmark progettato per valutare le capacità del modello nell'estrazione ed elaborazione di fatti distribuiti all'interno di testi estesi.

Risolvere compiti con una dimensione di contesto lunga richiede al modello di distinguere informazioni importanti da grandi quantità di dettagli irrilevanti. Per simulare questo comportamento, "nascondiamo" le frasi del compito originale tra le frasi di testo irrilevante che proviene da un'altra distribuzione strettamente correlata (vedi Figura 1).

Questo approccio è basato sui primi test "ago nel pagliaio". Si tratta di un test che mira a testare la capacità di un sistema AI di identificare, estrarre, o riconoscere un'informazione molto specifica o un elemento (l'"ago") da un vasto insieme di dati o informazioni non pertinenti (il "pagliaio"). Questo concetto può essere applicato in vari ambiti, come il riconoscimento di pattern, la ricerca di informazioni, il processamento del linguaggio naturale, e altri campi dell'AI dove il sistema deve dimostrare di poter effettivamente "trovare l'ago nel pagliaio".

Link

Paper

In Search of Needles in a 11M Haystack:Recurrent Memory Finds What LLMs Miss: paper originale

Github

BABILong: a long-context needle-in-a-haystack benchmark for LLMs