Rete Neurale Ricorrente (RNN): differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| Riga 22: | Riga 22: | ||

Di seguito, una panoramica dei principali strumenti e tecnologie disponibili per lavorare con le RNN. | Di seguito, una panoramica dei principali strumenti e tecnologie disponibili per lavorare con le RNN. | ||

== Esempio basilare di Backpropagation in una RNN == | |||

La retropropagazione (Backpropagation) è una forma di addestramento tipica dei modelli supervisionati (anche se la ritroviamo anche negli autoencoder). | |||

Supponiamo di avere la seguente configurazione della rete neurale minimale, ad uno strato: | |||

* Input: X = 2 | |||

* Peso: w = 0.5 | |||

* Bias: b = 0.1 | |||

* Funzione di attivazione: ReLU | |||

* Output desiderato: Y target = 5 | |||

* Learning rate: 0.1 '''''1)''''' Calcoliamo l’output delle rete neurale, lo chiamiamo Z: | |||

''Z = w ⋅ x + b = 0.5 ⋅ 2 + 0.1 = 1.1'' | |||

'''''2)''''' Applichiamo all’output della rete neurale la funzione di attivazione, utilizziamo la ReLU: | |||

''Y = ReLU (z) = max (0,z) = max (0,1.1) = 1.1'' | |||

'''''3)''''' Dato l’output, calcoliamo la funzione di perdita: | |||

''Loss = (Y target − Y)^2 = (5 − 1.1)^2 = 3.9^2 = 15.21'' | |||

Una volta ottenuto l’output e calcolata la funzione di perdita possiamo procedere con l’ottimizzare il risultato. L’obiettivo è di avvicinare il più possibile il nostro output Y al risultato atteso Y Target. | |||

Per fare ciò andiamo ad aggiustare i pesi w che non sono altro che di quanto viene moltiplicato l’output di un neurone prima di essere inserito come input nel neurone successivo. Ma come sappiamo quali pesi andare a toccare e di quanto? Ci vengono in aiuto i [[Gradienti di ottimizzazione|Gradienti]]! | |||

Il calcolo dei gradienti ci consente di trovare il valore ottimale di uno o più parametri di una funzione in modo che la curva risultante si adatti ai dati nel modo più accurato possibile. Nel caso delle reti neurali i parametri sono i pesi e l’obiettivo è minimizzare la funzione di perdita. | |||

== Framework e Librerie == | == Framework e Librerie == | ||

Versione delle 14:42, 12 mar 2024

Reti Neurali Ricorrenti

Le Reti Neurali Ricorrenti (RNN, dall'inglese Recurrent Neural Networks) sono un tipo di architettura di rete neurale particolarmente efficace nel trattare dati sequenziali. A differenza delle reti neurali tradizionali e delle reti neurali convoluzionali, le RNN sono capaci di gestire sequenze di vettori in input, output, o entrambi, rendendole strumenti potenti per applicazioni che richiedono la modellazione di dati temporali o sequenziali.

Caratteristiche delle RNN

Le RNN si distinguono per la loro capacità di operare su sequenze di lunghezza variabile, senza vincoli predeterminati sulla dimensione degli input o degli output. Questa flessibilità le rende ideali per una varietà di compiti, come la classificazione di sequenze temporali, la generazione di testo, la traduzione automatica e altre applicazioni nel campo del trattamento automatico del linguaggio naturale e della visione artificiale.

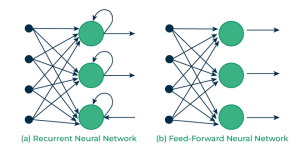

Una caratteristica fondamentale delle RNN è la loro memoria interna, che permette di conservare informazioni degli stati precedenti per influenzare le elaborazioni future. Questa memoria è realizzata attraverso connessioni ricorrenti all'interno della rete, che permettono di mantenere uno stato interno tra l'elaborazione di elementi successivi della sequenza.

Funzionamento delle RNN

Le RNN sono un'evoluzione delle reti Feed Forward.

Nel suo funzionamento più basilare infatti, una RNN elabora ogni elemento della sequenza uno alla volta, aggiornando il proprio stato interno in funzione dell'input corrente e dello stato precedente. Questo processo consente alla rete di tenere conto delle dipendenze temporali tra gli elementi della sequenza, offrendo così la capacità di modellare contesti e relazioni a lungo termine tra i dati.

La funzione di aggiornamento dello stato interno e l'output della rete sono tipicamente realizzati mediante strati densamente connessi e funzioni di attivazione non lineari, come la tangente iperbolica o la funzione ReLU. I parametri della rete (pesi sinaptici) vengono adattati durante la fase di addestramento utilizzando tecniche di ottimizzazione basate sul gradiente, come la discesa stocastica del gradiente, per minimizzare una funzione di perdita che misura la discrepanza tra gli output della rete e gli output desiderati.

Okay ma come si fa?

Per costruire una rete neurale si possono adottare vari approcci e framework, ciascuno con le proprie caratteristiche, vantaggi e comunità di utenti.

Di seguito, una panoramica dei principali strumenti e tecnologie disponibili per lavorare con le RNN.

Esempio basilare di Backpropagation in una RNN

La retropropagazione (Backpropagation) è una forma di addestramento tipica dei modelli supervisionati (anche se la ritroviamo anche negli autoencoder).

Supponiamo di avere la seguente configurazione della rete neurale minimale, ad uno strato:

- Input: X = 2

- Peso: w = 0.5

- Bias: b = 0.1

- Funzione di attivazione: ReLU

- Output desiderato: Y target = 5

- Learning rate: 0.1 1) Calcoliamo l’output delle rete neurale, lo chiamiamo Z:

Z = w ⋅ x + b = 0.5 ⋅ 2 + 0.1 = 1.1

2) Applichiamo all’output della rete neurale la funzione di attivazione, utilizziamo la ReLU:

Y = ReLU (z) = max (0,z) = max (0,1.1) = 1.1

3) Dato l’output, calcoliamo la funzione di perdita:

Loss = (Y target − Y)^2 = (5 − 1.1)^2 = 3.9^2 = 15.21

Una volta ottenuto l’output e calcolata la funzione di perdita possiamo procedere con l’ottimizzare il risultato. L’obiettivo è di avvicinare il più possibile il nostro output Y al risultato atteso Y Target.

Per fare ciò andiamo ad aggiustare i pesi w che non sono altro che di quanto viene moltiplicato l’output di un neurone prima di essere inserito come input nel neurone successivo. Ma come sappiamo quali pesi andare a toccare e di quanto? Ci vengono in aiuto i Gradienti!

Il calcolo dei gradienti ci consente di trovare il valore ottimale di uno o più parametri di una funzione in modo che la curva risultante si adatti ai dati nel modo più accurato possibile. Nel caso delle reti neurali i parametri sono i pesi e l’obiettivo è minimizzare la funzione di perdita.

Framework e Librerie

L'evoluzione nel campo del deep learning ha portato allo sviluppo di numerosi framework e librerie che semplificano la costruzione, l'addestramento e il deployment delle RNN. Ecco alcuni dei più popolari:

TensorFlow

TensorFlow (https://www.tensorflow.org/) è un framework open-source per il machine learning sviluppato da Google. Offre un'ampia gamma di strumenti e librerie per la costruzione di modelli di deep learning, inclusi modelli RNN per applicazioni come il riconoscimento vocale, la traduzione automatica e la generazione di testo. TensorFlow supporta sia l'esecuzione su CPU che su GPU e offre una flessibilità elevata per la ricerca e lo sviluppo di nuovi algoritmi.

PyTorch

PyTorch (https://pytorch.org/) è un framework di machine learning open-source sviluppato da Facebook. È particolarmente apprezzato nella comunità di ricerca per la sua flessibilità e il suo design orientato agli oggetti, che facilita la costruzione e l'esperimentazione di modelli complessi. PyTorch offre supporto completo per le RNN, comprese le variazioni come LSTM e GRU, e permette un'integrazione profonda con librerie Python per la scienza dei dati.

Keras

Keras(https://keras.io/) è un'interfaccia di alto livello per la costruzione di reti neurali, progettata per essere semplice da utilizzare pur mantenendo la flessibilità necessaria per la ricerca. Inizialmente sviluppata come interfaccia indipendente, Keras è ora integrata in TensorFlow come `tf.keras`. Offre moduli, layer e utility pre-costruiti per la creazione rapida di RNN, semplificando l'implementazione di modelli complessi.

Theano

Sebbene lo sviluppo di Theano (http://deeplearning.net/software/theano/) sia stato ufficialmente interrotto nel 2017, questa libreria è stata pionieristica nel campo del deep learning. Ha offerto un potente ambiente di calcolo simbolico per la definizione, ottimizzazione e valutazione di espressioni matematiche complesse, inclusi i modelli RNN. Theano ha gettato le basi per molti dei framework moderni.

Considerazioni sull'Utilizzo

Quando si sceglie un framework per lavorare con le RNN, è importante considerare diversi fattori:

- Community e Supporto: Una comunità attiva e una buona documentazione possono facilitare l'apprendimento e la risoluzione di problemi.

- Flessibilità vs. Semplicità: Mentre alcuni framework come PyTorch offrono maggiore flessibilità e controllo, altri come Keras puntano a semplificare la costruzione di modelli a scapito di una minore personalizzazione.

- Performance: Le differenze nelle prestazioni tra framework possono variare in base al tipo di modello RNN costruito e all'hardware utilizzato.

- Ecosistema: L'integrazione con altre librerie e strumenti di sviluppo può essere un fattore decisivo, specialmente per progetti complessi che richiedono più della semplice costruzione di modelli.

Sfide nell'addestramento delle RNN

Nonostante la loro potenza, le RNN possono essere difficili da addestrare efficacemente a causa di problemi come la dissipazione dei gradienti, che si verificano quando le informazioni relative agli errori si riducono o aumentano esponenzialmente lungo le sequenze durante la retropropagazione. Per mitigare questi problemi, sono state proposte variazioni sul tema delle RNN, come le Long Short-Term Memory (LSTM) e le Gated Recurrent Unit (GRU), che introducono meccanismi specifici per regolare il flusso di informazioni e mantenere stabile l'apprendimento lungo sequenze di grande lunghezza.

Applicazioni delle RNN

Le applicazioni delle RNN sono molteplici e spaziano in diversi campi dell'intelligenza artificiale. Nel campo del trattamento del linguaggio naturale (NLP), le RNN vengono utilizzate per la traduzione automatica, la generazione di testo e la comprensione del linguaggio. Nella visione artificiale, trovano impiego nella classificazione video e nella generazione di descrizioni per immagini. Altre applicazioni includono la previsione di serie temporali, la modellazione di sequenze musicali e la robotica.