LongAlign: differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| Riga 30: | Riga 30: | ||

|title=LongAlign | |title=LongAlign | ||

|title_mode=append | |title_mode=append | ||

|keywords= | |keywords=elaborazione del linguaggio naturale, apprendimento automatico, modelli linguistici di grandi dimensioni, LongAlign, intelligenza artificiale, deep learning, comprensione del linguaggio naturale, generazione di testo, analisi del testo, elaborazione di testi lunghi | ||

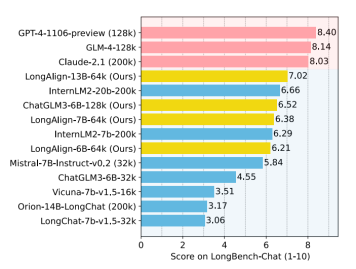

|description= | |description=LongAlign è una tecnica che migliora la capacità dei modelli linguistici di grandi dimensioni (LLM) di comprendere e gestire testi lunghi. L'articolo spiega come LongAlign utilizzi un set di dati specifico e tecniche di addestramento efficienti, come il 'packing' e il 'batching ordinato', per ottimizzare l'apprendimento. I test su LongBench-Chat dimostrano che LongAlign consente ai modelli di gestire testi da 10.000 a 100.000 caratteri, rispondendo a domande complesse in modo accurato. | ||

|image=Screenshot_2024-03-20_152310.png | |image=Screenshot_2024-03-20_152310.png | ||

}} | }} | ||

Versione attuale delle 13:47, 17 ago 2024

| LongAlign | |

|---|---|

| Nome | LongAlign |

| Sigla | |

| Anno di creazione | 2024 |

| URLHomePage | https://github.com/THUDM/ HomePage LongAlign |

| Pubblicazione | LongAlign: A Recipe for Long Context Alignment of Large Language Models |

LongAlign è una tecnica avanzata progettata per aiutare i grandi modelli di intelligenza artificiale a comprendere e gestire testi molto lunghi in modo più efficace. Questo metodo introduce un modo nuovo per preparare i modelli a capire meglio le istruzioni complesse e a rispondere in maniera più accurata su argomenti estesi.

Funzionamento di LongAlign:

1. Costruzione di un dataset specifico: Prima di tutto, LongAlign crea un insieme di dati appositamente progettato per addestrare gli LLM su contesti lunghi. Questo set di dati comprende esempi che coprono una vasta gamma di argomenti e formati, assicurando che il modello possa imparare a gestire una varietà di materiali lunghi.

2. Tecniche di addestramento efficienti: LongAlign utilizza strategie di addestramento innovative per accelerare il processo di apprendimento senza sacrificare la qualità. Due approcci chiave sono il "packing" e il "batching ordinato". Il packing consiste nel combinare insieme diversi pezzi di testo fino a raggiungere una lunghezza massima, ottimizzando l'uso delle risorse di calcolo. Il batching ordinato raggruppa i testi di lunghezza simile per minimizzare i tempi morti. Questi metodi aiutano il modello a imparare in modo più efficiente da grandi volumi di testo.

3. Valutazione su compiti complessi: LongAlign testa i modelli su LongBench-Chat, un benchmark che presenta domande di lunghezza reale da 10k a 100k caratteri. Questo tipo di valutazione assicura che il modello non solo possa gestire testi lunghi, ma che possa anche comprendere e rispondere a domande complesse basate su quei testi.

L'importanza di LongAlign risiede nella sua capacità di spingere i limiti di ciò che gli LLM possono fare. Tradizionalmente, gli LLM lottano con testi lunghi a causa delle limitazioni di memoria e attenzione, ma LongAlign offre un modo per superare tali limiti. Inoltre, il metodo garantisce che i modelli rimangano versatili, mantenendo alte prestazioni su una vasta gamma di compiti, sia che richiedano la gestione di poche righe di testo o l'analisi di interi documenti.

Link

Paper

LongAlign: A Recipe for Long Context Alignment of Large Language Models: paper originale

Github

https://github.com/THUDM/LongAlign