NETtalk: differenze tra le versioni

Nessun oggetto della modifica |

Nessun oggetto della modifica |

||

| (10 versioni intermedie di 3 utenti non mostrate) | |||

| Riga 1: | Riga 1: | ||

{{Template modello | |||

|NomeInglese=NETtalk | |||

|AnnoDiCreazione=1993 | |||

|URL=https://archive.ics.uci.edu/dataset/150/connectionist+bench+nettalk+corpus | |||

|Pubblicazione=Parallel Networks that Learn to Pronounce English Text | |||

}} | |||

Modello implementato negli anni '80 dalla ricerca di Terrence Sejnowski and Charles Rosenberg e uno dei primi esempi di applicazione delle [[reti neurali]] e di applicazione delle teorie del [[Connessionismo|connettivismo]] . | Modello implementato negli anni '80 dalla ricerca di Terrence Sejnowski and Charles Rosenberg e uno dei primi esempi di applicazione delle [[reti neurali]] e di applicazione delle teorie del [[Connessionismo|connettivismo]] . | ||

Questo modello, partendo da un dataset etichettato che associa circa 20000 parole inglesi alla loro trascrizione fonetica, dimostrò di essere in grado di generalizzare a parole sconosciute. Dal paper:<blockquote>English pronunciation has been extensively studied by linguists and much is known about the correspondences between letters and the ele- mentary speech sounds of English, called phonemes 183). English is a par- ticularly difficult language to master because of its irregular spelling. '''For example, the "a" in almost all words ending in "ave", such as "brave" and "gave", is a long vowel, but not in "have", and there are some words such as "read" that can vary in pronunciation with their grammatical role.''' The problem of reconciling rules and exceptions in converting text to speech shares some characteristics with difficult problems in artificial intelligence that have traditionally been approached with rule-based knowledge repre- sentations, such as natural language translation</blockquote> | |||

==== Architettura ==== | ==== Architettura ==== | ||

Da [[wikipedia:NETtalk_(artificial_neural_network)|wikipedia]]: | Da [[wikipedia:NETtalk_(artificial_neural_network)|wikipedia]]: | ||

* input: vettore da [[One-hot encodings|one-hot]] da 29 categorie | * input: vettore da [[One-hot encodings|one-hot]] da 29 categorie per sette lettere introdotte in modalità sliding window | ||

* layer nascosto: 80 unità | * layer nascosto: 80 unità | ||

* layer di output: 26 unità | * layer di output: 26 unità, rappresentazione fonetica della quarta lettera della sequenza di input | ||

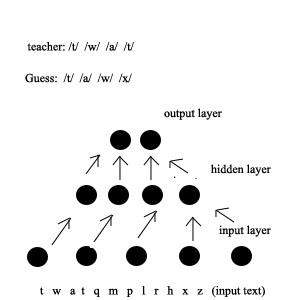

<blockquote>Representations of letters and phonemes. The standard network had seven groups of units in the input layer, and one group of units in each of the other two layers. Each input group encoded one letter of the input text, so that strings of seven letters are presented to the input units at anyone time. The desired output of the network is the correct phoneme, associated with the center, or fourth, letter of this seven letter "window". The other six letters (three on either side of the center letter) provided a partial context for this decision. T he text was stepped through t he window letter-by-letter. At each step, the network computed a phoneme, and after each word the weights were adjusted according to how closely the computed pronunciation matched the correct one.</blockquote>[[File:NETtalk-Back-propagation.jpg|nessuno|miniatura|NETtalk-Back-propagation (da Wikipedia)]] | |||

[[File:NETtalk-Back-propagation.jpg|nessuno|miniatura|NETtalk-Back-propagation (da Wikipedia)]] | |||

==== Esempi di input ==== | ==== Esempi di input ==== | ||

| Riga 21: | Riga 28: | ||

[https://archive.ics.uci.edu/dataset/150/connectionist+bench+nettalk+corpus Corpus di addestramento originale di NETTalk] | [https://archive.ics.uci.edu/dataset/150/connectionist+bench+nettalk+corpus Corpus di addestramento originale di NETTalk] | ||

[[Category:modello]] | [[Category:modello]] | ||

{{#seo: | |||

|title=NETtalk | |||

|title_mode=append | |||

|keywords=rete neurale, connessionismo, fonetica, linguaggio naturale, apprendimento automatico, intelligenza artificiale, elaborazione del linguaggio naturale, reti neurali artificiali, algoritmi di apprendimento, modelli linguistici | |||

|description=NETtalk è un modello di rete neurale sviluppato negli anni '80 che apprende a pronunciare parole inglesi. Il modello utilizza un set di dati di parole e trascrizioni fonetiche per imparare le corrispondenze tra lettere e suoni. NETtalk è stato uno dei primi esempi di successo dell'applicazione delle reti neurali all'elaborazione del linguaggio naturale. | |||

|image=NETtalk-Back-propagation.jpg | |||

}} | |||

Versione attuale delle 16:26, 17 ago 2024

| NETtalk | |

|---|---|

| Nome Inglese | NETtalk |

| Sigla | |

| Anno Di Creazione | 1993 |

| Versione Corrente | |

| URL | https://archive.ics.uci.edu/dataset/150/connectionist+bench+nettalk+corpus |

| Pubblicazione | Parallel Networks that Learn to Pronounce English Text |

| URL Pubblicazione | |

Modello implementato negli anni '80 dalla ricerca di Terrence Sejnowski and Charles Rosenberg e uno dei primi esempi di applicazione delle reti neurali e di applicazione delle teorie del connettivismo .

Questo modello, partendo da un dataset etichettato che associa circa 20000 parole inglesi alla loro trascrizione fonetica, dimostrò di essere in grado di generalizzare a parole sconosciute. Dal paper:

English pronunciation has been extensively studied by linguists and much is known about the correspondences between letters and the ele- mentary speech sounds of English, called phonemes 183). English is a par- ticularly difficult language to master because of its irregular spelling. For example, the "a" in almost all words ending in "ave", such as "brave" and "gave", is a long vowel, but not in "have", and there are some words such as "read" that can vary in pronunciation with their grammatical role. The problem of reconciling rules and exceptions in converting text to speech shares some characteristics with difficult problems in artificial intelligence that have traditionally been approached with rule-based knowledge repre- sentations, such as natural language translation

Architettura

Da wikipedia:

- input: vettore da one-hot da 29 categorie per sette lettere introdotte in modalità sliding window

- layer nascosto: 80 unità

- layer di output: 26 unità, rappresentazione fonetica della quarta lettera della sequenza di input

Representations of letters and phonemes. The standard network had seven groups of units in the input layer, and one group of units in each of the other two layers. Each input group encoded one letter of the input text, so that strings of seven letters are presented to the input units at anyone time. The desired output of the network is the correct phoneme, associated with the center, or fourth, letter of this seven letter "window". The other six letters (three on either side of the center letter) provided a partial context for this decision. T he text was stepped through t he window letter-by-letter. At each step, the network computed a phoneme, and after each word the weights were adjusted according to how closely the computed pronunciation matched the correct one.

Esempi di input

action @kS-xn 1<>0<< 0 activate @ktxvet- 1<>0>2<< 0 active @ktIv- 1<>0<< 0 activity @ktIvxti 0<>1<0<0 0

Links

Paper Originale: Parallel Networks that Learn to Pronounce English Text

Corpus di addestramento originale di NETTalk